激活函数

激活函数在神经网络中起着关键作用,主要用于引入非线性并增强模型的表现力和学习能力。以下是激活函数的主要作用和意义:

1. 引入非线性

- 作用:激活函数使神经网络能够建模复杂的非线性关系。

- 原因:如果没有激活函数(或仅使用线性变换),多层神经网络的组合仍然是线性的,等价于单层线性模型。非线性激活函数(如Sigmoid、ReLU、GELU)允许网络捕捉数据中的复杂模式,例如图像特征、语言语义等。

- 示例:对于异或(XOR)问题,线性模型无法解决,而加入非线性激活函数的神经网络可以轻松拟合。

2. 控制信号传播

- 作用:激活函数决定神经元的输出是否被激活或抑制,控制信息在网络中的传播。

- 机制:激活函数对输入加权和进行变换,决定输出值的大小和符号。例如,ReLU将负输入截断为0,稀疏化输出;Sigmoid将输出压缩到[0, 1],适合概率解释。

- 效果:通过选择性地激活神经元,激活函数帮助网络聚焦于重要特征,减少冗余计算。

3. 梯度传播与优化

- 作用:激活函数影响反向传播中的梯度计算,直接关系到模型的训练效果。

- 机制:激活函数的导数决定了梯度如何在网络中传播。例如:

- Sigmoid/Tanh可能导致梯度消失(导数接近0),不利于深层网络训练。

- ReLU导数为0或1,计算简单但可能导致“死亡神经元”(负输入梯度为0)。

- GELU、SiLU等平滑激活函数提供连续导数,改善梯度流。

- 效果:合适的激活函数(如ReLU、GELU)可以加速收敛,缓解梯度消失或爆炸问题。

4. 稀疏化与正则化

- 作用:某些激活函数(如ReLU、Leaky ReLU)通过将部分输出设为0,引入稀疏性。

- 好处:

- 计算效率:稀疏输出减少计算量,适合大规模网络。

- 正则化效果:稀疏性降低过拟合风险,增强模型泛化能力。

- 示例:ReLU在负输入时输出0,减少了不必要的神经元激活。

5. 任务适配性

- 作用:激活函数根据任务需求调整输出范围和特性。

- 示例:

- Sigmoid:输出[0, 1],适合二分类或概率预测。

- Softmax:输出归一化概率,适合多分类任务。

- Tanh:输出[-1, 1],适合需要零中心数据的场景。

- ReLU/GELU:适合回归或深度网络,输出范围灵活。

- 效果:选择合适的激活函数可以使输出更符合任务要求,提高模型性能。

6. 增强模型表达力

- 作用:激活函数通过多样化的非线性变换,增加网络的表达能力。

- 机制:不同激活函数(如GELU、Mish、ELU)具有独特的曲线形状,赋予网络不同的特征提取能力。例如,GELU结合高斯分布特性,适合Transformer模型;Mish通过平滑性和非单调性提升性能。

- 效果:现代激活函数(如GELU、SiLU)在复杂任务(如NLP、CV)中表现优于传统函数(如Sigmoid)。

注意事项

- 选择依据:激活函数的选择需考虑任务类型、网络深度、计算效率和梯度稳定性。例如,ReLU适合浅层网络,GELU/SiLU适合深层Transformer。

- 局限性:不合适的激活函数可能导致训练困难(如梯度消失)或性能下降(如ReLU的死亡神经元问题)。

- 发展趋势:现代深度学习倾向于使用平滑、梯度友好的激活函数(如GELU、Mish),以适应深层网络和复杂任务。

总结

激活函数是神经网络的核心组件,通过引入非线性、控制信号传播、优化梯度流、稀疏化输出和适配任务需求,显著提升模型的性能和表达能力。选择合适的激活函数是设计高效神经网络的关键步骤。

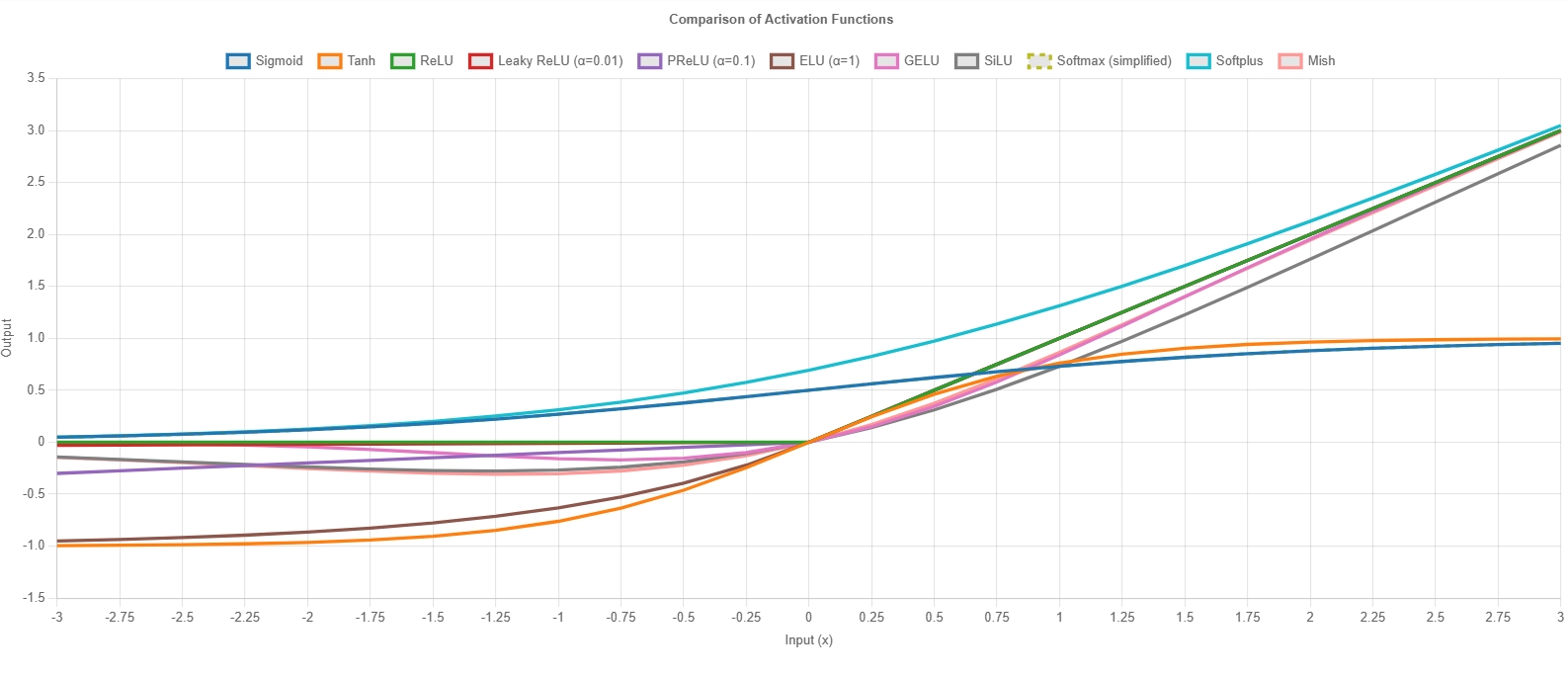

下面是激活函数的数学公式和曲线图: